Ch2 Intellignt Agents

Ch2 Intelligent Agents

Agents and Envirouments

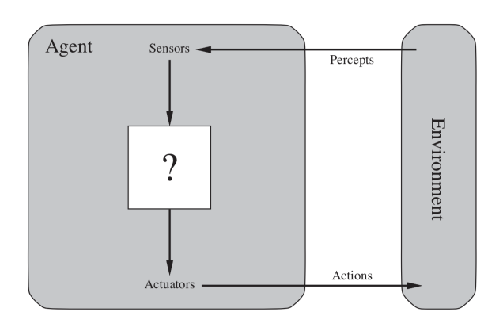

agent: anything can perceive its enviroument through sensors and act upon that enviroument through actuators

percept: means agent’s perceptual inputs at any given instant

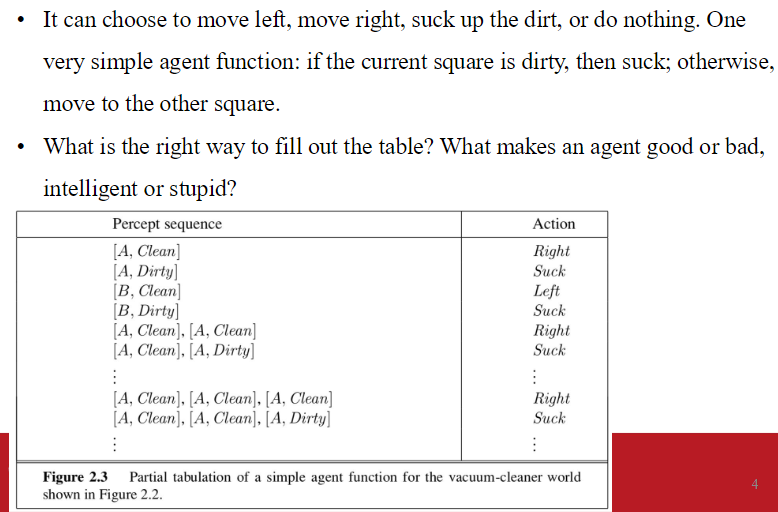

agent function: describe agent’s behavior through maps percept seq. to action

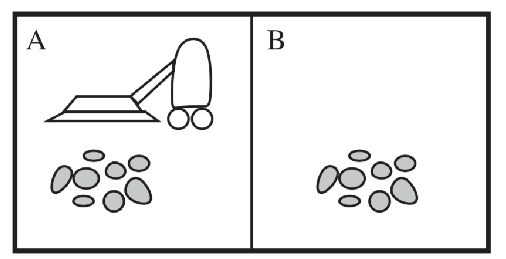

simple example, vecuum-cleaner

The concept of rationality

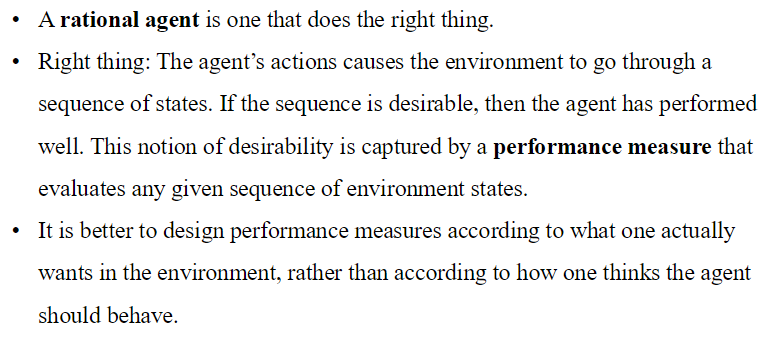

- rational agent: 做正確的事的agent

- right thing: 如果給定輸入seq.良好,表現就好。

- performance measure: 評定agent的期望性好不好。這個指標根據agent如何影響環境狀態序列而來

- better to design performance measure: 根據我們希望環境變得如何,而非agent該怎麼行動來設計

Rationality

- rational agent: 給出可能的percept sequence,選擇能夠最大化performance measure的行為。

- 根據 given evidence and bulit-in knowledge 推斷變化 做出選擇

- simple vacuum:

- 是否理性根據我們如何定義 performance measure

Omniscience, Learning, and Autonomy

- rationality: 使預期效能最大化

- perfection: 使實際效能最大化

- our definition: 不奢求omniscience,因為是基於 percept sequence 做出選擇。

- 不只希望收集訊息 還要agent盡可能從perceives學習

- rational agent: 自主的,能透過學習彌補錯誤或不正確的先驗知識

- incorportion of learning: 可以在多樣的環境中 設計出成功的 rational agent

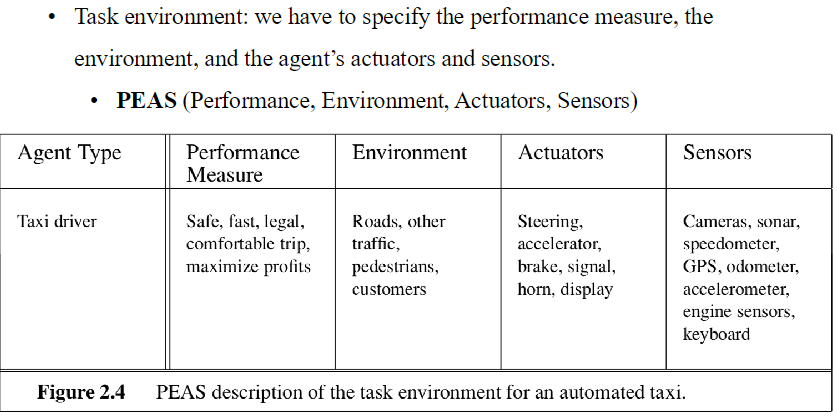

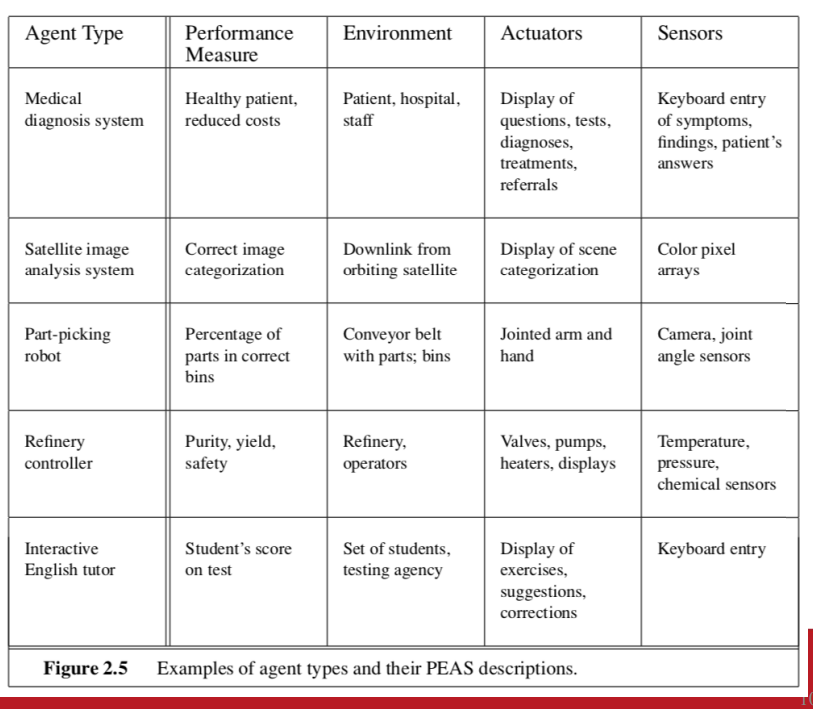

Task Enviroument

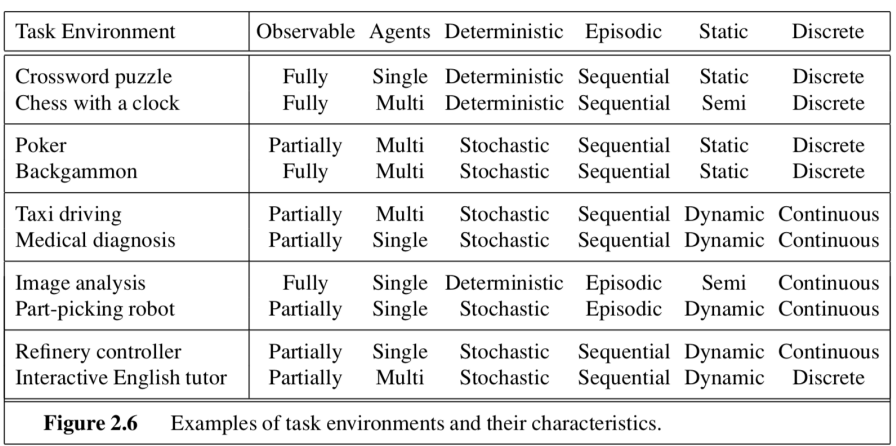

Properties of Task Environments

- Fully observable: sensors 能夠偵測所有與選擇行動有關的角度

- multi-agent: 當前agent最大化效能 是否需要考慮其他agent的行動

- Eg. chess game

- Deterministic vs. stochastic: 如果下一個環境狀態完全由現在狀態以及agent的行為決定 則屬於Deterministic。 在同一個環境中 每次做相同的決定 得到的結果相同。

- 如果帶有隨機性 則屬於stochastic。 通常用機率來表示這不確定性

- Episodic vs. sequential

- 下一個episode 不依賴於上一個episode的行為

- chess 和 taxi 屬於sequential

- Static vs. dynamic

- 如果agent思考的時候 環境會改變則屬於dynamic

- Discrete vs. continuous

- chess的環境狀態是有限的 因此屬於dicrete的percepts and actions

- taxi driving 就屬於 continuous-state and continuous-time problem

- known vs. unknown

- known 代表agent or designer 對於環境的規則、物理法則或行為模式完全了解。 agent能精準預測行動對環境狀態的影響

- Eg. chess game

- known 代表agent or designer 對於環境的規則、物理法則或行為模式完全了解。 agent能精準預測行動對環境狀態的影響

The structure of Agents

- jobs of AI: design an agent program

- architecture: 實體的sensors 以及 actuator

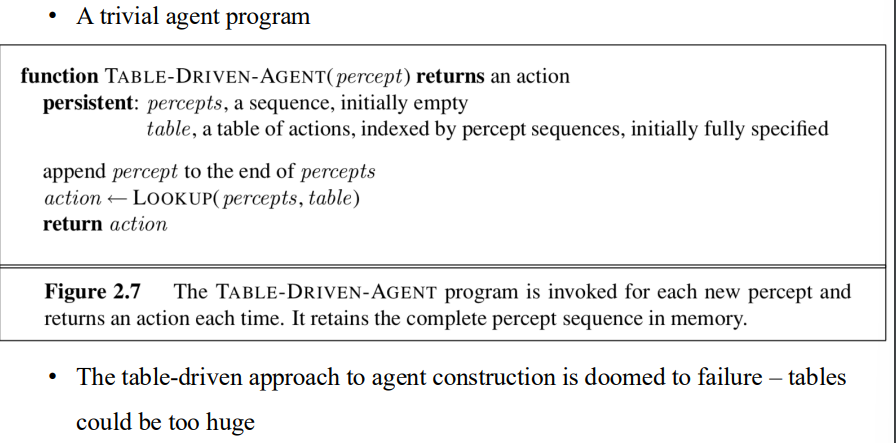

Agent Programs

- table-driven approach: 藉由對應表實現 agent program

- 通常是失敗的 表太大了

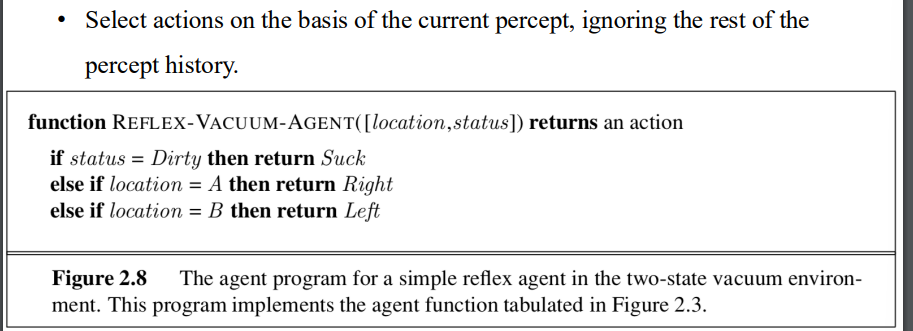

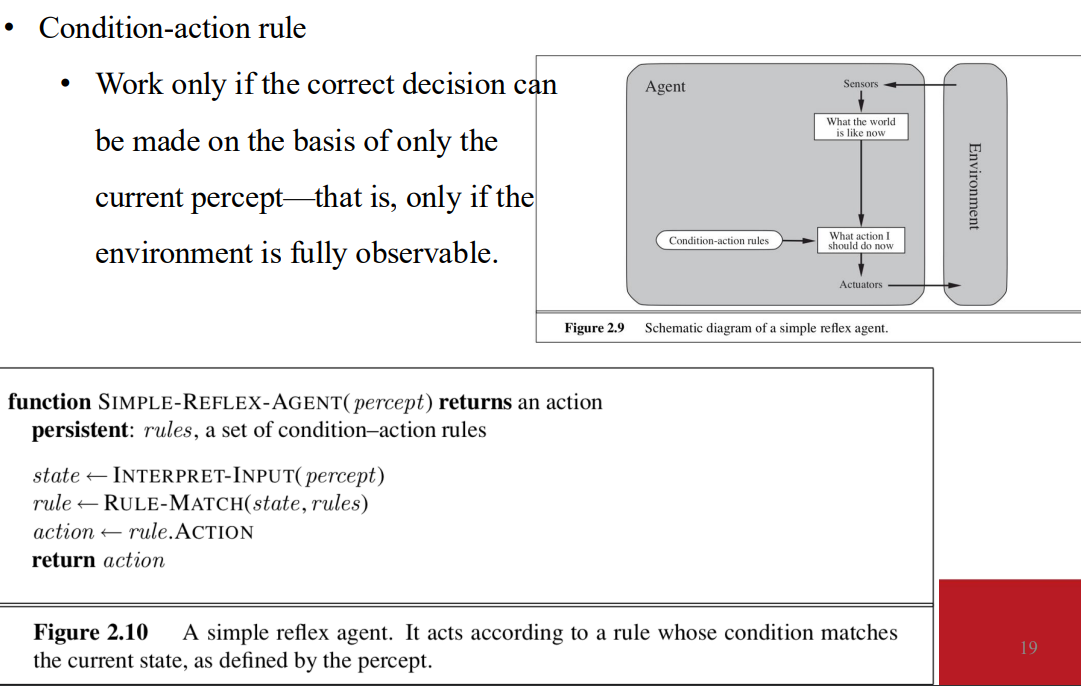

Simple Reflex Agents

- 根據當前的percept 決定行動。 忽略過去的percept

- 在fully observable的情況下有效 因為正確的決定取決於當下的percept

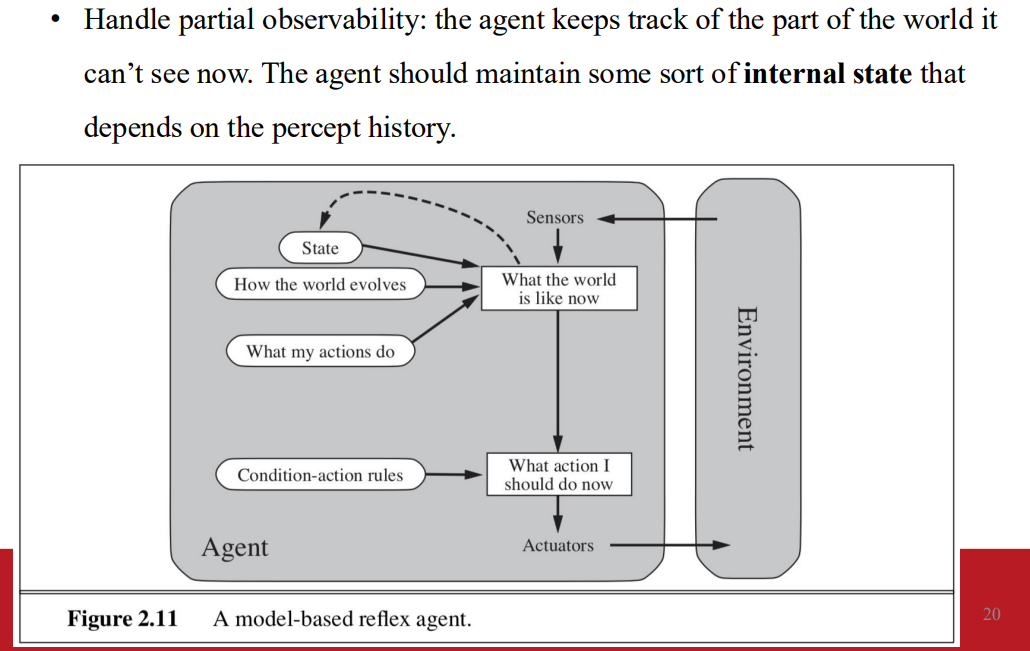

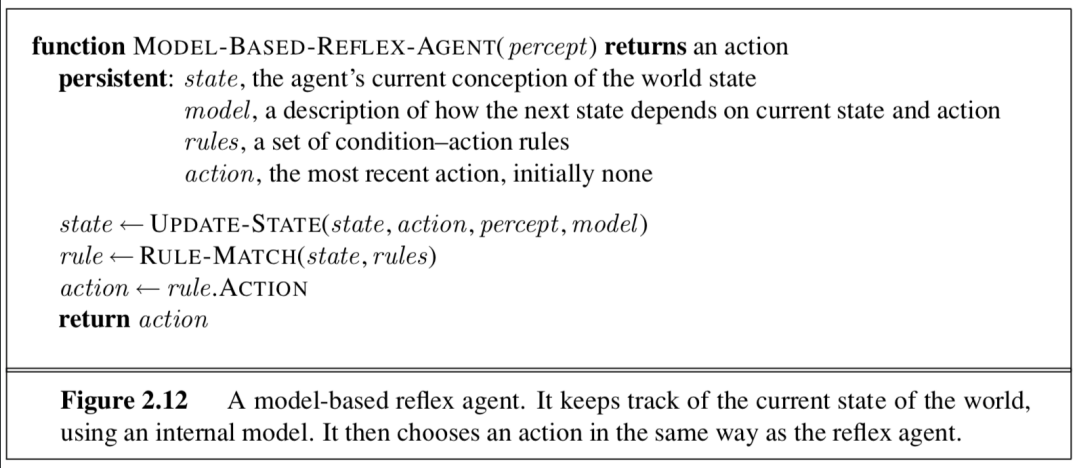

model-based reflex agent

- 紀錄了一部份當下看不見的訊息 會維護internal state 來源於過去的percept

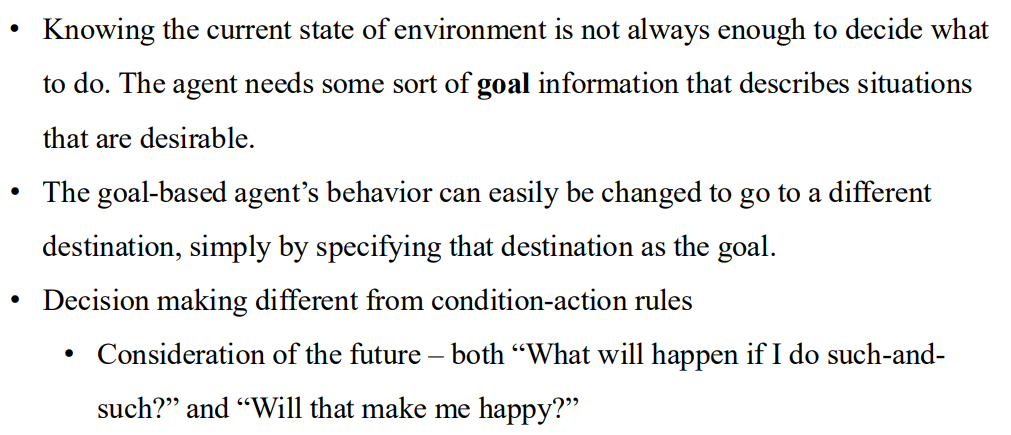

Goal-based Reflex Agent

- 僅靠當前環境資訊無法做出最佳行動決策 還需要目標資訊

- 導航系統不只需要當前車輛位置 還需要目的地位置

- goal information: 定義哪些狀態可達成或理想的

- 具備靈活性 只要更改目標 就能切換agent的行動

- agent: 尋找能最大化達成目標的行動

- 不同於condition-action rules: 會考慮結果是否更靠近目標

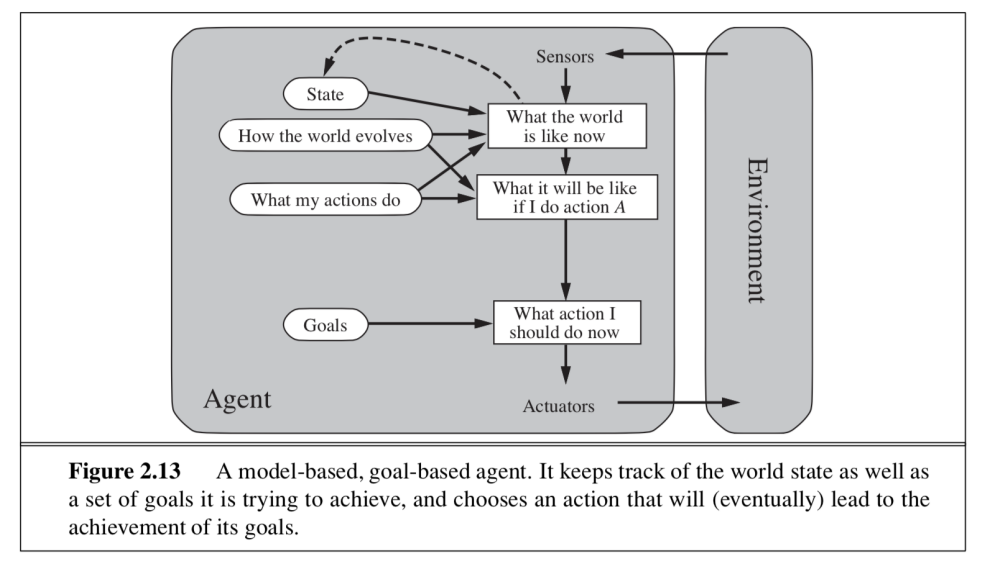

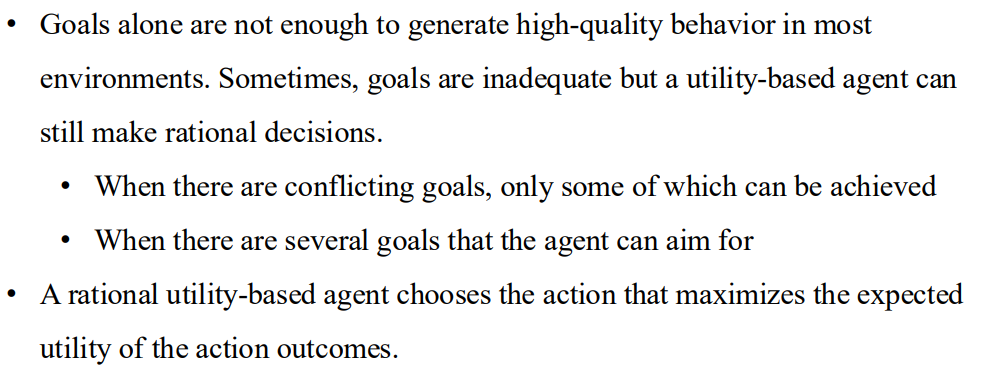

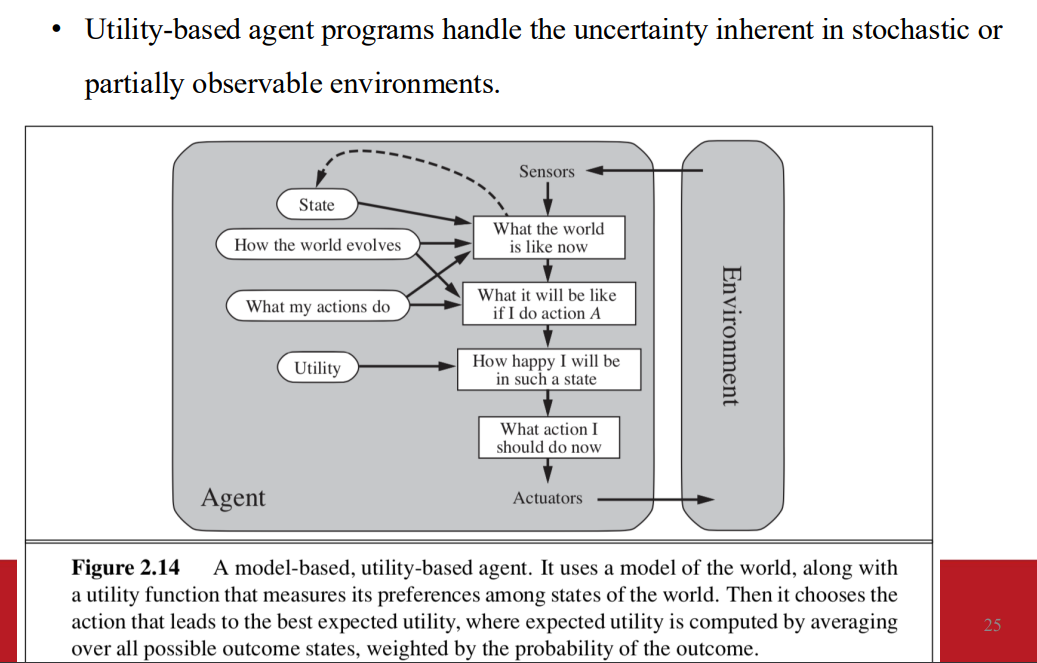

Utility-based Reflex Agent

- 當goal information不足以選出最佳的選擇

- 衝突的目標 只能實現其中之一

- 多個可行的目標 該如何選擇

- agent 選擇能夠讓 expected utility 最大化的行為

- 用於衡量多個選擇的優先程度

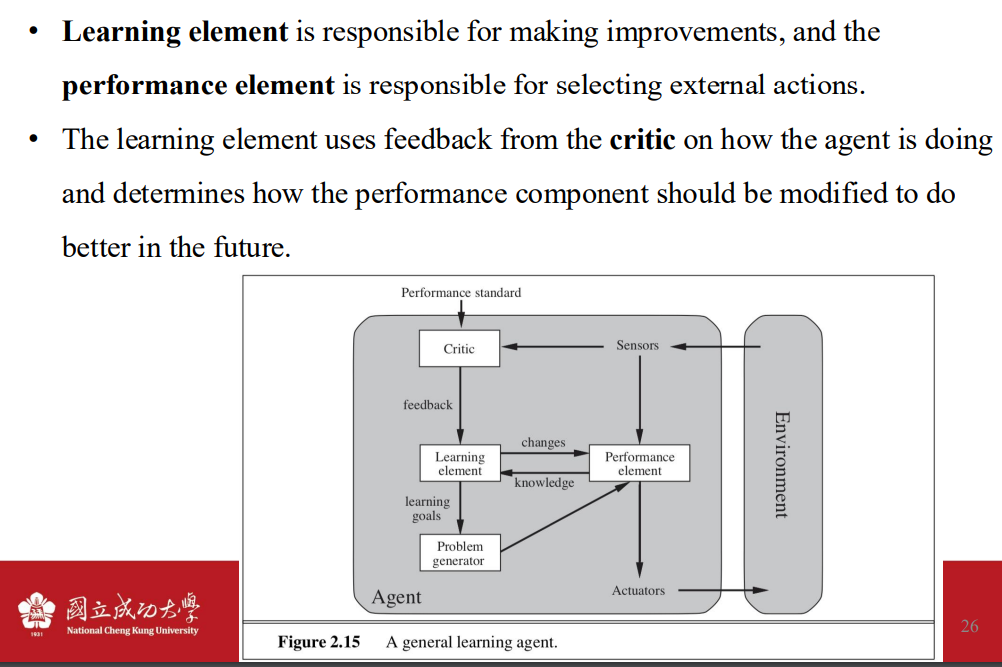

Learning agents

- performance element: 負責根據環境的percept行動

- learning element: 負責用學習機制改進agent行為

- 接收來自critic的回饋 調整performance element

- problem generator: 負責產出建議的行動 帶來更豐富的經驗

- 在短期行動中 嘗試次好的選擇 有機會在長期的行動中 找到更好的決策

- 學習是透過修改各個組件 以期望與 available feedback information更加一致

Ch2 Intellignt Agents

https://z-hwa.github.io/webHome/[object Object]/Introduction to Artificial Intelligence/Ch2-Intellignt-Agents/